Schülerzahlprognosen, Statistik und Bildungspolitik(er)

Harald Walser diskutiert in seinem Blogeintrag vom 28. Juni 2013 die zukünftige Entwicklung der NMS (neuen Mittelschule).

Er schreibt dort

Die NMS verliert bis 2030 laut Schulbesuchsprognose (Quelle Statistik Austria) 1.600 Klassen und 34.000 SchülerInnen (29.000 an die AHS, 5.000 geringere Geburtenrate)

Ausgangspunkt sind folgende Daten:

| Hauptschule | AHS | |

|---|---|---|

| 2009/10 | 233.228 | 115.651 |

| 2015/16 | 210.239 | 118.933 |

| 2020/21 | 202.119 | 124.685 |

| 2025/26 | 199.813 | 134.084 |

| 2030/31 | 199.210 | 144.802 |

Die Daten stammen aus dem Artikel

Regionalisierte Schulbesuchsprognose für Österreich 2009 bis 2030

in den Statistischen Nachrichten 2/2012 der Statistik Austria

Dort findet man gleich zu Beginn folgende Feststellung:

Die Entwicklung der Neuen Mittelschule wird in dieser Studie noch nicht gesondert behandelt und ausgewiesen, da hier zum Zeitpunkt der Prognoserechnung noch die notwendigen Informationen über den weiteren Ausbau und die künftige Standortpolitik fehlten. Die Zahlen und Trends der Hauptschule und AHS-Unterstufe beinhalten somit auch Klassen der Neuen Mittelschule, die an solchen Standorten bereits existieren oder künftig noch errichtet werden.

Das heißt im Klartext, dass die Autoren der Prognose gar nicht erst versuchen, mögliche Veränderungen der Aufteilung zwischen HS/NMS und AHS-Unterstufe abzuschätzen, weil die Daten dafür keine ausreichende Grundlage bieten.

Prognosen sind ja praktisch immer Fortschreibungen von in der Vergangenheit beobachteten Trends, und über die Auswirkungen der NMS gibt es erst so wenige Daten, dass da eine Fortschreibung nicht gerechtfertigt ist.

Der Versuch, aus diesen Daten irgendwelche politische Folgerungen über Erfolg oder Scheitern den NMS abzuleiten ist unzulässig!

Statistische Prognosen sind der Versuch, mit Hilfe von Mathematik Unsicherheit zu quantifizieren. Beim PISA-Test gibt es in der Mathematik eine Subskala „Unsicherheit“. Da hat Österreich bei PISA 2003 (da wurde diese Skala das letzte Mal erhoben und publiziert) eher unterdurchschnittlich abgeschnitten. Anscheinend gibt es auch auf politischer Ebene gewisse Probleme, Unsicherheiten vernünftig abzuschätzen.

Es gibt aber noch ein weiteres Problem, nämlich die Darstellung der Daten. Da findet sich im zitierten Blog eine Form, die das Erkennen der behaupteten Entwicklung nicht gerade erleichtert.

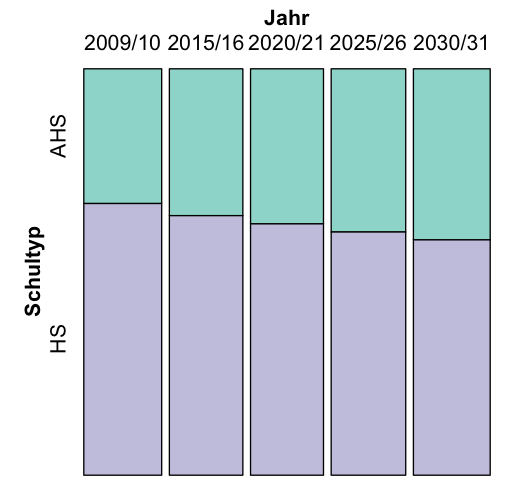

Um die zeitliche Entwicklung der Aufteilung der Schüler auf zwei Schultypen zu untersuchen sollte man die Daten mit einer leicht verständlichen und problemadäquaten Grafik darstellen. Grafiktypen, mit dem man das gut untersuchen kann, sind gestapelte Stabdiagramme oder noch besser Mosaik-Diagramme. Das sieht dann so aus:

In einer derartigen Grafik sieht man auf den ersten Blick, dass sich in der Prognose der Statistik Austria der Anteil der AHS-Schüler bei den 10-15-Jährigen erhöht, die HS(/NMS)-Schüler aber immer noch eine deutliche Mehrheit bilden.

Und außerdem ist diese Grafik eine Fortschreibung der Entwicklung vor Einführung der NMS, also zur Beurteilung der „Anziehungskraft“ der NMS vollkommen ungeeignet.

Wir Statistiker sind hoffnungslose Optimisten. Wir hoffen unbeirrbar, dass bei Prognosen auch darüber nachgedacht und gesprochen wird, was da in welcher Form fortgeschrieben wird.

Auch wenn das immer wieder nicht geschieht hoffen wir weiter!

Die Beschäftigungsquote, das Schulsystem und PISA

Die OECD lobt das österreichische duale Ausbildungssystem. Es führt zu einer niedrigen Arbeitslosigkeit.

Das duale Ausbildungssystem zeigt sich im Schulsystem in drei Schulformen:

- Berufsschulen (BS)

- Berufsbildende mittlere Schulen (BMS)

- Berufsbildende höhere Schulen (BHS)

Wie man in einem früheren Blogeintrag nachlesen kann sind BS und BMS jene Schultypen, die an den nur mittelmäßigen PISA-Ergebnissen Österreichs die Hauptschuld tragen.

Die Existenz dieser Schulformen wird als als Grund für unsere sehr gute Beschäftigungslage gesehen.

Wir müssen uns wohl sehr genau ansehen, wie wir diese positiven Effekte bewahren können, wenn wir das Schulsystem massiv ändern.

Ich möchte nicht missverstanden werden: Diese Tatsachen sind nicht billig als Argument gegen die Gesamtschule verwertbar. Sie zeigen aber, dass das Problem vielschichtig ist und dass man daher Änderungen im Bildungssystem so machen sollte, dass man möglichst viele Nebenwirkungen im Auge behält.

Schülerleistungen und Lehrerunterstützung: PISA und TALIS

Es gibt wieder ein neues Aufregerthema in der Bildungspolitik. Österreich nimmt 2013 an der TALIS-Studie nicht teil. Diese Studie erhebt (durch Befragung) unter anderem institutionelle Infrastruktur, Jobzufriedenheit und berufliche Selbsteinschätzung von Lehrern. Bei der letzten Studie (2008) sind für die Bildungspolitik wenig erfreuliche Ergebnisse herausgekommen. Bei der institutionellen Unterstützung für Lehrer schaut’s da im internationalen Vergleich relativ schlecht aus.

Frau BM Schmied begründet die Nichtteilnahme so

Das Ministerium habe sich vor eineinhalb Jahren aufgrund extremer Kostenüberschreitungen des Bifie dazu entschieden, nicht an TALIS 2013 teilzunehmen. Zudem habe es keine Veränderungen bei Arbeitszeit oder Dienstrecht in Österreich gegeben, die sich in der Studie niederschlagen hätten können. Andere Daten wie Arbeitszeit und Gehalt seien außerdem etwa in der jüngst veröffentlichten OECD-Studie „Bildung auf einen Blick 2013“ erhoben worden.

(siehe beispielsweise Salzburger Nachrichten vom 26.6.2013)

In der Presse vom 25.6.2013 liest man zu diesem Thema

Er (Haider, ehemaligen Direktors des Bundesinstituts für Bildungsforschung (Bifie)) warf Schmied in einem Gastkommentar im „Kurier“ indirekt vor, kritische wissenschaftliche Daten, die der Gewerkschaft in den Verhandlungen den Rücken stärken könnten, bewusst zurückzuhalten bzw. deren Erhebung zu verbieten. Haider ist mit seinem Verdacht nicht allein, wie „Die Presse“ nun erfahren hat.

Die öffentliche Diskussion beschäftigt sich wieder einmal nahezu ausschließlich mit der tagespolitischen Verwertbarkeit vor Forschungsergebnissen.

Niemand spricht davon, daß mit TALIS diesmal ganz neue Einsichten möglich gewesen wären.

Die teilnehmenden Länder hatten diesmal bei TALIS die Möglichkeit, die Daten an genau jenen Schulen zu erheben, an denen im vergangenen Jahr die PISA-Tests durchgeführt wurden. Man hätte also aus diesen Daten unmittelbar Rückschlüsse auf den Zusammenhang zwischen der beruflichen Situation der Lehrer und den Leistungen von Schülern ziehen können.

Vergleichbares war bei der letzten TALIS-Studie nicht möglich, und auch der neue OECD-Bericht Education at a Glance 2013 untersucht solche Zusammenhänge nicht mit derselben Schlüssigkeit, die mit TALIS möglich gewesen wäre.

Wieder einmal wurde also ein Chance vergeben, möglicherweise überraschende Erkenntnisse über unser Bildungssystem zu gewinnen.

Aber auch hier steckt wohl das dahinter, womit man als Statistiker meist zu kämpfen hat:

in politischem Kontext sind statistische Untersuchungen nur dann erwünscht, wenn die Ergebnisse bereits vorher gefasste Meinungen unterstützen. Eine Untersuchung, die neue Fragen untersucht, bei denen man die Antworten noch nicht kennt, wird kaum je in Auftrag gegeben.

Ökonomische Wahrheiten, Wissenschaftliche Forschung und Excel

Einr leicht gekürzte Fassung dieses Artikels ist am 20. Juli 2013 in der

Wiener Zeitung erschienen

Kenneth Rogoff ist Professor für Ökonomie an der Harvard University und in der ganzen Welt anerkannt. Dort ist auch Carmen Reinhart Professorin. Die beiden haben 2009 und 2010 in mehreren Publikationen festgestellt, dass eine Staatsschuldenquote von mehr als 90% (gemessen am BIP) sich sehr negativ auf das Wirtschaftswachstum auswirkt. Wenn Autoritäten dieses Kalibers so etwas behaupten, dann wird das natürlich oft in dem Medien zitiert und viele Politiker verwenden diese wissenschaftliche Erkenntnis als Rechtfertigung für ihre Forderungen nach mehr Sparanstrengungen zur Eindämmung der Staatsverschuldung.

Ein Wesenszug der Wissenschaft ist es, dass man publizierte Ergebnisse und Behauptungen sehr kritisch überprüft. Deshalb haben Kollegen der beiden versucht, die Analyse nachzuvollziehen. Das ist lange Zeit hindurch nicht gelungen. Es war nicht ganz klar, welche Daten da eigentlich verwendet wurden, und es war auch nicht ganz klar, welche Berechnungen zum Ergebnis geführt haben.

Seit einigen Tagen gibt es jetzt einen neuen Bericht der drei Wissenschafter Thomas Herndon, Michael Ash, and Robert Pollin von der University of Massachusetts, Amherst. Sie haben die Daten von Rogoff und Reinhart bekommen und versucht, die Analyse der beiden nachzuvollziehen. Dabei stießen sie auf drei Probleme. Erstens: Die Ausgangsdaten von Reinhart und Rogoff stammen aus 20 Ländern und betreffen die Jahre 1946-2009. Allerdings wurden manche Jahre aus manchen Ländern nicht in die Berechnungen einbezogen, und es gibt keine schlüssige Begründung, warum diese Daten aus der Analyse ausgeschlossen wurden. Zweitens: Die Analysen werden nicht mit den verfügbaren Einzeldaten gerechnet, sondern die Daten wurden in Gruppen zusammengefasst und innerhalb Gruppen pro Land Mittelwerte errechnet. In der Analyse werden dann nur die Mittelwerte verwendet. Problematisch dabei ist, dass die Anzahl der Werte pro Land in den Gruppen verschieden gross ist und daher bei der Mittelwertsbildung die einzelnen Daten sehr verschieden gewichtet werden. Drittens: bei der Berechnung in Excel wurde eine falsche Formel verwendet. Die Daten aus 5 der 20 Länder wurden durch diesen Formelfehler aus den endgültigen Berechnungen ausgeschlossen.

Die drei Wissenschafter aus Amherst haben zunächst mit etwas Mühe diese drei Probleme identifiziert und dann alle Berechnungen noch einmal durchgeführt. Dabei blieb das politisch so bedeutsame Ergebnis von Reinhart-Rogoff auf der Strecke, die Wachstumsrate der untersuchten Volkswirtschaften ist auch bei einer Verschuldungsrate von über 90% nicht dramatisch niedriger als bei einer geringeren Verschuldungsrate. In beiden Analysen wurden die Daten in 4 Gruppen eingeteilt:

- Jahre mit höchstens 30%,

- zwischen 30% und 60%,

- zwischen 60% und 90% und

- mehr als 90% Verschuldung.

Die BIP-Änderungsraten aller Länder wurden für die in diese Gruppen fallenden Jahre jeweils gemittelt. Ein Vergleich der urspünglichen Ergebnisse von Reinhart-Rogoff und der von Herndon-Ash-Pollin korrigierten Ergebnisse sieht so aus:

| 0%-30% | 30%-60% | 60%-90% | 90+% | |

|---|---|---|---|---|

| Reinhart-Rogoff | 4,1% | 2,8% | 2,8% | -0,1% |

| Herndon-Ash-Pollin | 4,2% | 3,1% | 3,2% | 2,2% |

Es gibt also schon die Grundtendenz, dass das Wachstum mit zunehmender Verschuldung geringer wird, aber die plakative Feststellung, dass es ab 90% Verschuldung dramatische Einbrüche beim Wachstum, ja sogar Schrumpfen gibt, ist wohl nicht haltbar.

Warum hat niemand das früher entdeckt? Weil es in der Wissenschaft noch nicht allgemein üblich ist, bei publizierten Ergebnissen dafür zu sorgen, dass Interessierte die Analyse so vollständig wie möglich nachvollziehen und überprüfen können. Man muss kein promovierter Volkswirt sein, um die Schwachstellen in den behaupteten Ergebnissen zu finden, die notwendigen mathematischen Kenntnisse gehen über die Grundrechnungsarten nicht hinaus. Man braucht allerdings die Originaldaten, oder zumindest eine Beschreibung, die genau genug ist, genau diese Originaldaten selbst am Internet zu finden. Dabei wäre es ganz einfach gewesen. Die gesamten Ausgangsdaten samt Analyse sind eine eher kleine Excel-Datei. Die hätten die Autoren einfach ins Internet stellen und auf ihrer Website verlinken können, und schon wäre Forschung insgesamt wieder ein Stückchen transparenter geworden.

In der universitären und forschungsorientierten Statistik gibt es seit einigen Jahren das Thema „Reproducible Research“. Dabei handelt es sich vereinfacht gesagt um die Entwicklung von Software, die es ermöglicht, Daten und Analysen gemeinsam so zur Verfügung zu stellen, dass weiteren Forschern (oder auch anderen Interessierten) das Nachvollziehen und Überprüfen möglichst einfach gemacht wird. Eines der ersten Werkzeuge dieser Art wurde übrigens von einem österreichischen Wissenschafter, Friedrich Leisch, jetzt an der Universität für Bodenkultur, entwickelt und ist international in Fachkreisen sehr bekannt.

Wie wichtig die Überprüfung von Forschungsergebnissen ist zeigt auch ein Beispiel aus der Medizin. Anil Potti, Mediziner an der Duke University, publizierte als sensationell eingestufte Ergebnisse, mit denen man, wenn sie stimmen, für einzelne Patienten massgeschneiderte Therapien für bestimmte Krebsformen entwickeln könnte. Als andere Forscher versuchten, die Ergebnisse zu reproduzieren, scheiterten sie. Die Daten der Pottischen Untersuchungen standen zunächst nicht komplett zur Verfügung. Aber selbst in den verfügbaren Teilen der Daten liessen sich (mit relativ großer Mühe und statistischer Detektivarbeit) Inkonsistenzen und ziemlich schwere Fehler nachweisen. Als diese Kritik in einer statistischen und nicht in einer medizinischen Zeitschrift veröffentlicht wurde, wurden einige der medizinischen Arbeiten zurückgezogen und Anil Potti wurde von der Universität entlassen. Die publizierten Ergebnisse waren einfach nicht haltbar.

Auch in Österreich hatten wir ein Problem mit unvollständig publizierten Daten.

Als die Ergebnisse von PISA 2003 bekanntgegeben wurden war in der gesamten Medienlandschaft von einem Absturz die Rede. Im Nachhinein hat sich dann herausgestellt, dass es bei PISA 2000 eine systematische Verzerrung der österreichischen Ergebnisse durch falsche Gewichtung der Untergruppen Schultyp und Geschecht gegeben hatte. PISA publiziert sehr viele Daten, aber es war mit den veröffentlichten Daten alleine nicht möglich, den Fehler zu entdecken und zu korrigieren, weil die Information über den Schultyp in diesen Daten „geschwärzt“ war. Auch hier war ein vergleichsweise aufwändiger Prozess notwendig, um Zugang zu diesen Daten zu bekommen und die Fehler und ihre Ursachen so genau zu identifizieren, dass eine Korrektur möglich war.

In allen drei Fällen waren die behandelten Forschungsfragen von großem öffentlichen Interesse. Wären die Ergebnisse richtig gewesen, dann hätten sie entweder zu weitreichenden politischen Folgerungen oder zu einigermassen dramatischen medizinischen Fortschritten führen können.

In allen drei Fällen war es für andere Forscher zunächst immens schwierig, die Ergebnisse zu überprüfen oder gar zu korrigieren. Man sollte daher in Zukunft bei Forschungsergbnissen von grosser Tragweite immer zwei Fragen stellen: Wer hat das überprüft und welches Material stand dabei zur Verfügung? Und besser noch: Kann ich die Daten bekommen, damit ich mich selbst davon überzeugen kann, dass das, was da gesagt wird, auch stimmt?

Zum Artikel von Herndon-Ash-Pollin

Wikipedia-Eintrag zu Anil Potti

Probleme bei PISA 2000 und 2003 in Österreich

Bloggen kann helfen

In meinem letzten Beitrag habe ich beklagt, dass die Wahlanalyse von ISA und SORA für die Landtagswahl in Tirol die Anzahl der Befragten in den Untergruppen (z.B. nach Geschlecht und Alter) nicht ausweist. Man kann deswegen die Schwankungsbreite und damit die Zuverlässigkeit der politischen Folgerungen nicht beurteilen.

Eine Woche später gabs dann wieder eine Landtagswahl.

Und bei der Analyse der Landtagswahl Salzburg findet man diese Zahlen schon. Leider nur im Anhang. Leser- und benutzerfreundlich wäre es, die Zahlen direkt bei den Grafiken anzugeben, weil man dann die Zuverlässigkeit der Aussagen gleichzeitig mit den Aussagen selbst erfassen könnte. Noch leserfreundlicher wäre es natürlich, auch die aus den Befragtenzahlen errechneten Schwankungsbreiten ebenfalls direkt bei den einzelnen Grafiken anzugeben.

Vielleicht teilen uns ISA und SORA diese wichtigen Zusatzinformationen bei der nächsten großen Wahl, der Nationalratswahl im Herbst, mit.