Herdenimmunität – was ist das eigentlich?

Ich glaube, dass der Begriff „Herdenimmunität“ derzeit so oft verwendet wird, dass da viele Missverständnisse entstehen, was damit eigentlich gemeint ist.

Grundsätzlich geht es um Folgendes:

Bei einer Infektionskrankheit ist ein ganz wichtiger Begriff die Basisreproduktionszahl, das ist die durchschnittliche Anzahl der noch nicht Infizierten, die ein Infizierter mit durchschnittlichem Kontaktverhalten ansteckt. Die Schätzungen bei COVID-19 gehen da von einem Faktor 3 aus.

Wie breiten sich Epidemien aus?

Es gibt sehr viele Informationen zur Entwicklung der Zahl der COVID-19 Erkrankten.

Unter anderem heißt es, dass es wichtig ist, die Kurve zu verflachen.

Ich habe ein kleines mathematisches Modell erstellt, der das entsprechende Phänomen illustriert.

In diesem Modell gibt es drei Gruppen in der Gesamtpopulation:

- Suszeptible (Noch nicht erkrankte, die noch erkranken können)

- Infizierte

- Gesundete

Das Modell geht grob vereinfachend davon aus, dass einmal Gesundete nicht mehr erkranken und auch keine anderen mehr infizieren können (Todesfälle berücksichtigt das Modell nicht).

Die Fortschreibung der Zahlen im Modell funktioniert so.

Wir gehen davon aus, dass jede Person pro Tag eine fixe Zahl von Kontakten mit anderen Personen hat. Bei einem Kontakt zwischen einer suzeptiblen und einer infizierten Person kommt es mit einer bestimmten Wahrscheinlichkeit zu einer Infektion; in diesem Fall wird die suszeptible Person zur infizierten Person.

Eine weitere Modellannahme besagt, dass jede infizierte Person nach einem fixen Zeitraum gesund wird.

Mathepuzzle: Zwei Spiele hintereinander gewinnen

Bei einer Spielserie muss man ein Spiel 3x hintereinander spielen. Man gewinnt eine Serie, wenn man 2x hintereinander gewinnt.

Es gibt 2 Gegner, eine besseren, bei dem man mit geringerer Wahrscheinlichkeit gewinnt, und einen schwächeren, bei dem man mit höherer Wahrscheinlichkeit gewinnt.

Man muss abwechselnd gegen die beiden Gegner spielen.

Wann hat man die besseren Gewinnchancen, wenn man zuerst gegen den schwächeren oder zuerst gegen den besseren Gegner spielt?

Wie wahrscheinlich ist es, mit 2 Würfeln eine ungerade Augensumme zu würfeln.

Ich (@neuwirthe) poste regelmäßig (unter dem hashtag #mathepuzzle) mathematische Rätselaufgaben.

Vor einigen Tagen war das folgende Aufgabe:

Sie würfeln mit 2 Würfeln. Wie groß ist die Wahrscheinlichkeit, eine ungerade Summe zu würfeln.

Ich habe das für eine ganz einfache Aufgabe gehalten, aber zu meiner Überraschung hat sich gezeigt, dass die Aufgabe für viele meiner Follower schwerer war als ich erwartet habe.

Rohstoffbedarf berechnen

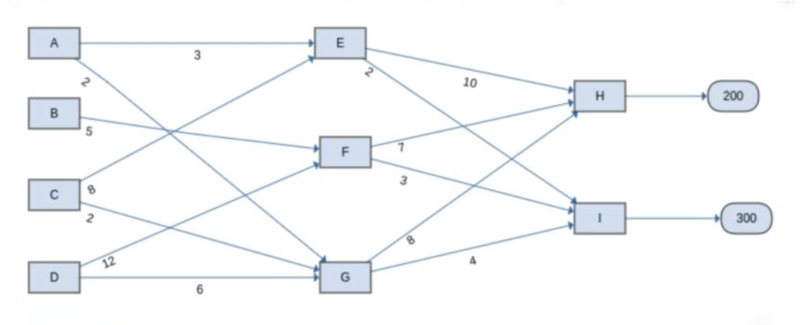

Das folgende Diagramm beschreibt einen Produktionsprozess.